Como continuacion al anterio

articulo de este blog, en este post me gustaria dar un enfoque diferente a como se aborda de forma tradicional la

Gestión de la Continuidad y su viculacion con la

Gestion de la Disponibilidad dentro del alcance de un proyecto de Virtualizacion de Servidores o/y en el caso de un proyecto especifico a tal efecto y/o finalmente dentro de la explotacion de un servicio; con el conocido software

VMWare Site Recovery Manager.

Son muchas y conocidas las ventajas que aporta este tipo de software en los referente a la

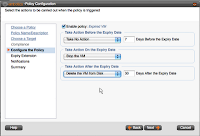

VIRTUALIZACION, como es la integracion con los distintos sistemas de almacenamiento multivendor (EMC, NetApp, IBM, etc...) de proposito general ya sean cabinas de tipo SAN (protocolos FC, FCoE) o dispositivos NAS (rotocolos CIFS, NFS, iSCSI) y sobre todo por la naturaleza de los servidores implementados como maquinas virtuales (VMS) la posibilidad de gestionar y automatizar un plan de recuperacion ante desastres de una forma mucho mas agil, dinamica y funcional que una prueba de contingencia en un entorno fisico, tal y como se puede apreciar en las imagenes adjuntas.

Sin embargo, al margen de su coste una de sus posibles desventajas reside en la naturaleza misma de dicho producto, debido a que esta diseñado y desarrollado para implantar planes de contigencia en el caso concreto de un escenario de

DATACENTER ACTIVO - PASIVO lo que esta relaccionado directamente con la replicacion (normalmente sincrona, al margen de si la fibra es oscura y dedicada o multiplexada a través de equipos DWDM) entre dos sistemas de almacenamiento ubicados cada uno de ellos en un CPD diferente actuando el pricipal como origen del entorno de Produccion y el secundario como destino (directamente relaccionado con los dos indicadores de gestion fundamentales en este aspecto de las infraestructuras:

RTO y

RPO).

Por otro lado, para implementar un plan de recuperacion ante desastres (es decir un DRP: Disaster Recovery Plan) como parte tecnologica dentro de un plan de continuidad de negocio (es decir BCP: Business Continuity Plan) es posible analizar otras opciones que pasan por la generacion de una SAN extendida (de tipo FRABRIC) y una LAN extendida entre los distintos CPDs implicados; contituyendo asi un

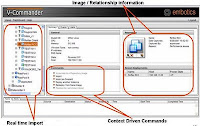

DATACENTER ACTIVO - ACTIVO tal y como se puede apreciar en la imagen final del escrito.

En un

primer escenario, es especialmente importante la configuracion de un cluster extendido (HA, DRS) entre los hypervisores de cada CPD con su propio sistema de almacenamiento como Datastore compartido entre ambos centros de datos, pero ubicado y funcionando unicamente en uno de ellos. Este es precisamente el punto de fallo de mayor impacto ya que la caida de la cabina de almacenamiento requiere que se disparen procesos de respaldo tradicionales ya sean manuales o automatizados lo que implica la aceptacion de un tiempo de parada en la prestacion del servicio y su posterior restablecimiento con un rendimiento al 100%. Sin embargo la posibilidad de mover servidores (VMs) entre los sites implicados supone una ventaja a considerar.

En un

segundo escenario, es especialmente importante el balanceo de carga y la alta disponibilidad de los productos que se ejecutan en las maquinas virtuales (VMs) dentro de cada cluster local de hypervisores, ya que se debe ser especialmente riguroso para conseguir una distribucion donde los pesos de los dos sitios sean del 50% con su propio sistema de almacenamiento como Datastore no compartido entre ambos centros de datos. La ventaja principal reside en que el servicio no solo esta protegido ante la caida de los hypervisores que conforman el cluster local, sino que ademas esta cubierto ante la caida del sistema de almacenamiento de forma directa sin la necesidad de activar ningun proceso ya sea este de tipo automático o manual y sobre todo sin suponer en ningun caso la parada en la prestacion del servicio. La desventaja consiste en la perdida de rendimiento ya que el 50% de los servidores (VMs) que daba servicio esta caido y unicamente se presta el servicio por el otro site que aporta el 50% de la capacidad de procesamiento. Este ultimo esquema es compatible con soluciones que automatizan planes de contingencia tradicionales como hemos visto, aunque no seria necesario si ante una situacion de contingencia esta validada y prevista la prestacion del servicio con la mitad de rendimiento.

Otra de las

buenas practicas (compatible con ambos escenarios descritos) que esta directamente relacciona con la

Gestion de la Configuracion ante planes de contigencia y de recuperacion ante desastres en un entorno de

VIRTUALIZACION es la agrupacion de los servidores (VMs) que prestan un determinado servicio de forma completa en Aplicaciones Virtuales (vAPPs) y la asignacion de una LUN dedicada a dicha vAPP, siempre y cuando no sea un requerimiento de los productos que corren en las VMs la asignacion dedicada de la LUN (RDM).